Un deepfake scatenerà la guerra nucleare?

FAVOREVOLE O CONTRARIO?

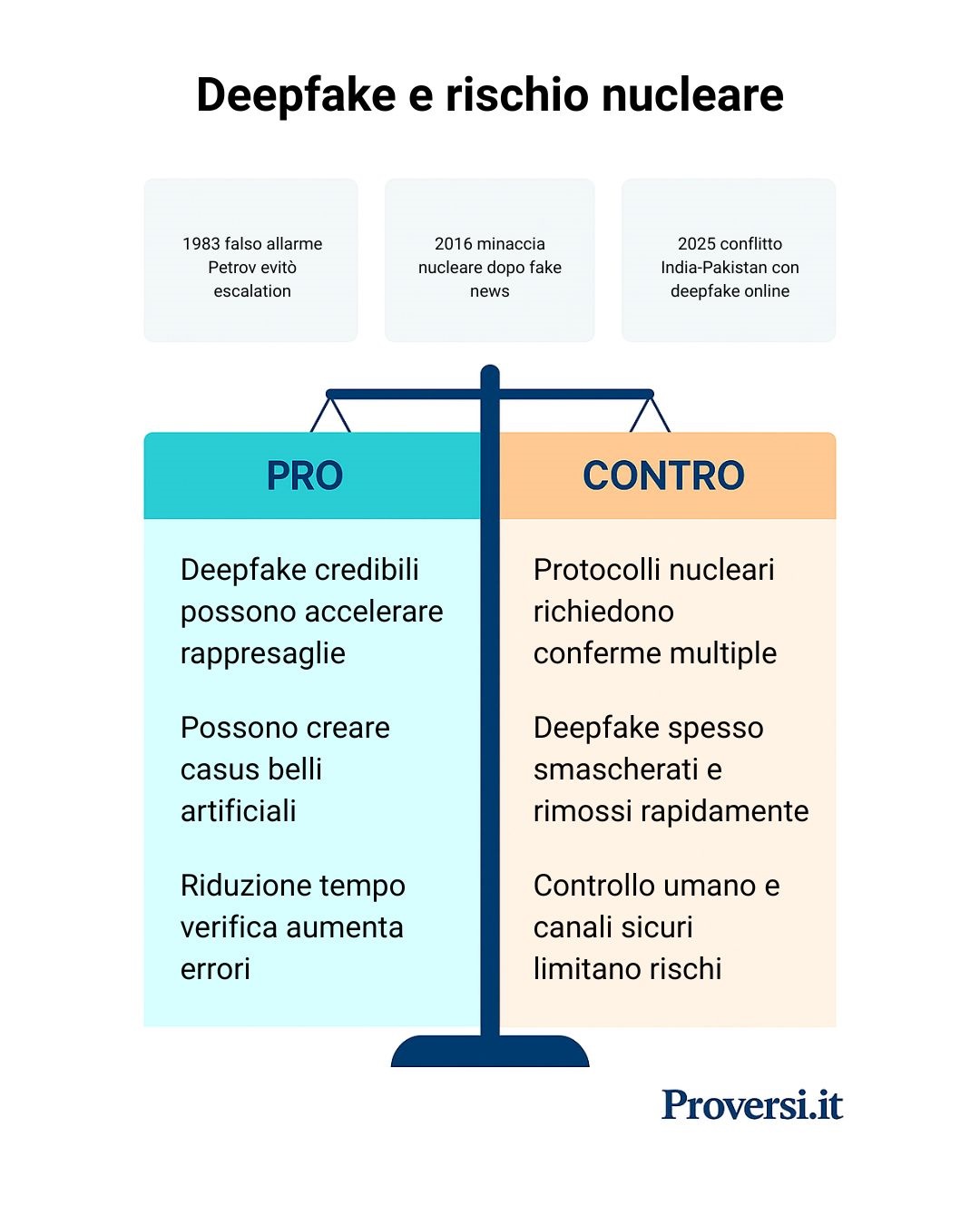

I progressi della tecnologia deepfake – la creazione tramite intelligenza artificiale di video o audio falsi ma altamente realistici – sollevano un inquietante interrogativo: un falso convincente potrebbe innescare per errore una guerra nucleare? La discussione è passata rapidamente dalla fantascienza alla realtà del dibattito pubblico, specialmente dopo che analisti e leader politici hanno avvertito che i deepfake potrebbero amplificare drasticamente il rischio di escalation atomica. Alla fine del 2025 la rivista “Foreign Affairs” ha lanciato l’allarme: l’uso crescente di deepfake e di sistemi d’arma automatizzati nell’ecosistema nucleare starebbe già indebolendo la stabilità strategica globale.

IL DIBATTITO IN 2 MINUTI:

Un deepfake che simuli un attacco nucleare potrebbe indurre la controparte a lanciare missili prima di verificarne la falsità, innescando un’escalation.

La dottrina nucleare prevede conferme multiple e intervento umano: un video fake non basterebbe a scatenare un attacco atomico.

Regimi o attori ostili potrebbero usare deepfake per fabbricare false prove di aggressione, creando casus belli artificiali e spingendo l’avversario a reagire.

Con la crescente consapevolezza e strumenti migliorati, è difficile che un falso inganni tutti.

L’AI e i deepfake rendono le crisi più veloci e confuse, riducendo il tempo per valutare i segnali e aumentando il rischio di errori di calcolo sotto pressione.

Uno scenario di guerra causato da un deepfake è improbabile: le decisioni restano in mano all’uomo, finora nessun falso digitale ha innescato un conflitto.

I falsi convincenti erodono la fiducia reciproca: se non ci si può fidare delle comunicazioni, la deterrenza perde credibilità e aumenta il rischio di reazioni impulsive.

La storia è piena di depistaggi: gli eserciti hanno procedure per gestirle. I deepfake non rivoluzionano la guerra, ma rientrano nella disinformazione già nota.

Un video falso può far partire i missili

In molti sostengono che un deepfake realistico potrebbe ingannare i sistemi d’allarme e i leader, scatenando un lancio nucleare per errore. Nei moderni protocolli “launch-on-warning” delle superpotenze, i comandanti hanno pochi minuti per reagire a un allarme missilistico: un video contraffatto, ad esempio in cui il presidente avversario annuncia un attacco atomico, potrebbe indurre una risposta immediata prima che la falsità venga scoperta. L’ex presidente USA Donald Trump ha descritto proprio uno scenario simile, chiedendo a Elon Musk se un Capo di Stato avrebbe modo di verificare in tempo reale l’autenticità di un video simile; la risposta sarebbe stata che “non c’è alcun modo”. Un caso storico emblematico evidenzia la gravità del problema: nel 1983 l’ufficiale sovietico Stanislav Petrov ignorò un allarme automatico (che segnalava erroneamente missili in arrivo) evitando una catastrofe. Se Petrov avesse seguito il computer – come potrebbe accadere a futuri “Petrov digitali” di fronte a un deepfake ben orchestrato – l’URSS avrebbe lanciato testate nucleari contro un attacco inesistente. Gli esperti notano che, quando un filmato manipolato di un presunto attacco diventa virale, i leader subiscono un’enorme pressione a “fare qualcosa” immediatamente, anche senza aver verificato i fatti. Un falso convincente, diffuso nei convulsi minuti iniziali di una crisi, rischia quindi di innescare la spirale escalation–rappresaglia tipica della deterrenza nucleare, stavolta però basata su un’illusione tecnologica creata ad arte.

Madeleine Maresca, 21 gennaio 2026

Verifiche incrociate frenerebbero gli inganni

I critici dell’allarmismo deepfake fanno notare che le procedure nucleari prevedono rigorosi controlli incrociati e intervento umano a ogni livello, rendendo molto difficile che un video falso da solo basti a scatenare una guerra. Le decisioni di lancio atomico non si basano su voci di corridoio o filmati online, ma su codici di autorizzazione, sensori militari e comunicazioni sicure tra governi. Ad esempio, se circolasse un video ambiguo di minaccia nucleare, i vertici militari cercherebbero conferme nei dati radar/satellitari e tramite linee dirette con l’altro paese prima di reagire. Nel 2016 fu proprio un rapido fact-checking diplomatico a disinnescare il caso Pakistan–Israele: Tel Aviv smentì ufficialmente via Twitter la falsa dichiarazione attribuita al suo ministro e lo scontro rientrò senza conseguenze. Su scala più ampia, tutte le potenze nucleari hanno ribadito che il controllo umano resta imprescindibile: persino Stati Uniti e Cina hanno dichiarato congiuntamente nel 2024 che manterranno l’uomo nel circuito decisionale riguardo alle armi nucleari. Analisti confermano che vi è un consenso generale a non delegare all’AI funzioni critiche come l’autorizzazione al fuoco atomico. Questo implica che un deepfake, per quanto allarmante, da solo non potrebbe bypassare i protocolli: servirebbero comunque codici di lancio validi e ordini confermati tramite canali protetti. Inoltre, la comunità internazionale sta già correndo ai ripari sul fronte comunicazioni: si discute di hotline cifrate e autenticate via AI per evitare spoofing (tecnica informatica di inganno), affinché in emergenza i leader possano riconoscere con certezza l’identità dell’interlocutore. Finché rimane in vigore questa rete di cautele – con doppi controlli umani e tecnologici – è altamente improbabile che un video artefatto, per quanto ben fatto, scateni da solo una reazione nucleare.

Madeleine Maresca, 21 gennaio 2026

Qualche leader potrebbe usare pretesti digitali per scatenare conflitti

Secondo questa tesi, i deepfake non costituiscono solo un pericolo accidentale ma possono diventare vere armi di provocazione deliberata. Un governo ostile o un gruppo terrorista potrebbero fabbricare prove audiovisive false per giustificare un attacco preventivo o per far collidere tra loro due potenze nucleari (false flag digitale). Gli analisti definiscono i deepfake una possibile “arma di distrazione di massa”, capace di creare pretesti artificiali per la guerra e di manipolare l’opinione pubblica per alimentare il consenso al conflitto. Già nel 2016 un semplice sito complottista riuscì a innescare uno scambio di minacce nucleari tra Pakistan e Israele diffondendo una notizia inventata; con i moderni strumenti AI, un aggressore potrebbe fare molto di più – ad esempio divulgando un video in cui un leader “annuncia” un attacco atomico imminente per spingere il nemico a colpire per primo. Studi recenti avvertono che anche attori non-statali potrebbero deliberatamente creare escalation: basterebbe un deepfake di un Capo di Stato che suggerisce di aver già impiegato armi nucleari per seminare caos e spingere gli avversari al brinkmanship (gioco al rilancio nucleare). Perfino se tali falsi venissero scoperti poco dopo, avrebbero comunque instillato panico e incertezza generalizzata nel momento cruciale della crisi. In sintesi, i sostenitori di questa tesi vedono nei deepfake un rischio concreto di casus belli virtuali: sofisticate macchinazioni in grado di far scoppiare guerre reali sulla base di bugie, sfruttando la naturale difficoltà di verifica immediata delle informazioni nelle situazioni di crisi.

Madeleine Maresca, 21 gennaio 2026

I deepfake sono difettosi e smascherabili

Gli scettici sottolineano che i deepfake, specialmente in ambito geopolitico, finora si sono rivelati goffi tentativi rapidamente smentiti. Il famigerato video fake di Zelenskyy del 2022, ad esempio, era di qualità così scadente (testa pixellata, voce non convincente) che è stato subito smontato dal pubblico e rimosso dalle piattaforme social. Nel giro di minuti Zelenskyy pubblicò un messaggio autentico di smentita, ridicolizzando la “provocazione”. I sostenitori di questa linea argomentano che più la tecnologia deepfake avanza, più crescono anche le contromisure: governi, ricercatori e aziende tech stanno sviluppando algoritmi di rilevamento automatico (basati su anomalie nei video AI, metadati ecc.) e sistemi di autenticazione delle fonti. Nel 2024 la Casa Bianca ha emanato un ordine esecutivo che obbliga a marcare i contenuti generati da AI e a potenziare gli strumenti anti-deepfake. Parallelamente, le grandi piattaforme hanno aggiornato le policy per bannare i media manipolati che incitino all’odio o alla violenza (Twitter/X, ad esempio, oggi etichetta i contenuti “ritoccati” e ne limita la diffusione). Anche la coscienza pubblica sta aumentando: sapendo dell’esistenza dei deepfake, cittadini e media ormai accolgono con scetticismo qualunque video sensazionale non verificato da fonti indipendenti. In definitiva, i deepfake sono un’arma spuntata: non appena provano a “bucare lo schermo” su larga scala, finiscono per essere riconosciuti e neutralizzati dalla combinazione di vigilanza collettiva e contro-tecnologie di sicurezza.

Madeleine Maresca, 21 gennaio 2026

I tempi rapidi imposti dalla tecnologia creano crisi lampo e decisioni al buio

L’avvento di AI e deepfake sta comprimendo drammaticamente i tempi di reazione nelle crisi nucleari, aumentando il rischio di errori fatali. L’integrazione di algoritmi nei sistemi di allerta può sì migliorare il rilevamento di minacce, ma riduce il tempo a disposizione dei leader per valutare segnali ambigui. Gli esperti parlano di “trappola dell’accelerazione”: le decisioni strategiche rischiano di dover essere prese alla velocità delle macchine, avvicinandosi pericolosamente al “pilota automatico”. In tali condizioni, un deepfake inserito nel flusso di informazioni di early-warning (per esempio falsificando dati satellitari o comunicazioni di comando) potrebbe far deragliare il processo decisionale prima che un operatore umano se ne accorga. Esperimenti citati sul “Bulletin of Atomic Scientists” mostrano che alcuni modelli di AI, simulando scenari di crisi, tendono per bias interno a fornire consigli di escalation ai decisori. Se in futuro i governi dovessero impiegare l’AI come supporto alle decisioni, ciò potrebbe spingere verso risposte più rapide e aggressive del necessario. Soprattutto, un errore dell’AI – ad esempio un’“allucinazione” di attacco – potrebbe generare allarmi falsi così credibili da non lasciare ai responsabili politici il tempo (o gli elementi) per smentirli. Marion Messmer, direttrice del programma Sicurezza internazionale di Chatham House, avverte che un modello neurale può prendere la decisione sbagliata e che gli operatori umani potrebbero non avere tempo né informazioni per contestarla: uno scenario estremamente pericoloso se riguarda il “lanciare o meno” ordigni nucleari. L’accoppiata AI/disinformazione, dunque, promette crisi sempre più fulminee e caotiche, in cui i leader potrebbero trovarsi a decidere “al buio” – basandosi su flussi informativi potenzialmente contaminati – con margini di ripensamento ridottissimi.

Madeleine Maresca, 21 gennaio 2026

Sulle deepfake c’è allarmismo esagerato, l’uomo resta al comando

Gli scettici ritengono che l’idea di un conflitto nucleare causato da un deepfake sia in gran parte uno scenario iperbolico, alimentato dalla fantapolitica più che da evidenze. Notano che finora nessun confronto atomico è stato nemmeno sfiorato a causa di deepfake o simili – i casi citati dai proponenti (1983, 2016) mostrano semmai che gli esseri umani, opportunamente allertati, sanno riconoscere e correggere gli errori dei sistemi automatici. Da decenni emergono paure per ogni nuova tecnologia (dagli allarmi satellitari negli anni ’60 al bug dell’Y2K nel 2000, fino alle cyber fake news recenti); in molti casi queste preoccupazioni non si sono tradotte in realtà concrete. Lo stesso vale per i deepfake: la comunità internazionale è consapevole del pericolo e dispone di robusti anticorpi, per cui ipotizzare un conflitto mondiale scatenato da un video artefatto appare tuttora fantascientifico. Gli esperti ammettono che la disinformazione può acutizzare le tensioni, ma valutano come molto bassa la probabilità di un’escalation nucleare dovuta unicamente a un inganno digitale. I protocolli di comando nucleare sono progettati per filtrare i falsi allarmi – retaggio della Guerra Fredda – e includono molteplici livelli di verifica umana. Anche qualora un generale o un presidente venisse tratto in inganno da immagini o audio artefatti, altri ufficiali e consulenti avrebbero l’opportunità di fermare decisioni impulsive prive di riscontri oggettivi. In definitiva, secondo questa visione l’allarme sui deepfake ricorda altre “nuove paure” tecnologiche poi ridimensionate: meglio concentrarsi su problemi più concreti di stabilità nucleare (come il rinnovo degli accordi di controllo degli armamenti) anziché su scenari da thriller digitale.

Madeleine Maresca, 21 gennaio 2026

La deterrenza nucleare è minata dalla post-verità

I deepfake potrebbero mettere in crisi i fondamenti psicologici della deterrenza nucleare, basati su comunicazioni credibili e fiducia minima tra le parti. Nell’era della “post-verità” digitale, in cui ogni immagine o messaggio può essere artefatto, diventa arduo distinguere le reali intenzioni nemiche dalle manipolazioni. Analisti del “Bulletin” notano che la marea di false informazioni (video contraffatti, notizie inventate) corrode la credibilità dei segnali genuini di deterrenza, alimentando paranoie e incomprensioni. Ad esempio, se un Paese lanciasse un allarme autentico o inviasse un messaggio urgente tramite canali pubblici, il suo avversario potrebbe liquidarlo come un deepfake nemico e non reagire adeguatamente – oppure, all’opposto, un leader potrebbe abboccare a una provocazione fake scambiandola per un ultimatum vero. In entrambi i casi, l’equilibrio del “mutuo terrore” su cui si basa la pace armata verrebbe compromesso. Studi dell’European Leadership Network classificano i deepfake come “armi di distorsione di massa” proprio perché riducono la chiarezza informativa e possono degradare i sistemi di comando e controllo nucleare (NC3). Se i decisori non si fidano più dei dati e delle comunicazioni – o perché temono siano falsi, o perché sono essi stessi bersaglio di campagne ingannevoli – aumenta il rischio di errori di valutazione. Mishra evidenzia che l’introduzione dei deepfake rende sempre più difficile per i leader distinguere l’informazione corretta da quella fuorviante, lasciandoli svantaggiati e incerti durante le crisi. Il fenomeno dei deepfake erode quindi la fiducia strategica residua tra le potenze nucleari e abbassa la soglia oltre la quale possono scatenarsi reazioni ostili, anche in assenza di reali aggressioni.

Madeleine Maresca, 21 gennaio 2026

Non c’è nulla di rivoluzionario nei deepfake, le difese sono collaudate

I critici contestano chi sostiene che i deepfake rappresentino un fattore davvero nuovo rispetto alle tradizionali tecniche di depistaggio e propaganda, contro cui gli apparati di sicurezza si sono attrezzati da decenni. Nella storia militare l’inganno del nemico è prassi antica (dai finti bersagli sugli schermi radar alle operazioni sotto falsa bandiera), e i comandanti hanno imparato a non reagire a caldo su informazioni non verificate. Gli stessi deepfake rientrano ormai tra gli “strumenti comuni” della guerra psicologica e della disinformazione strategica, ma non hanno sinora alterato l’esito di alcun confronto: durante la crisi tra India e Pakistan del 2025, entrambi i fronti diffusero video e immagini manipolate, suscitando paura e confusione nell’opinione pubblica, ma i leader mantennero la freddezza necessaria a prevenire un olocausto nucleare. In sostanza, l’arsenale di contromisure esistente (intelligence dedicata al debunking in tempo reale, protocolli di autenticazione dei messaggi critici ecc.) viene ritenuto più che sufficiente a neutralizzare i rischi legati ai deepfake. Questi ultimi non sarebbero un “game changer” geopolitico, ma solo l’ennesimo mezzo con cui i governi tentano di confondere gli avversari: tentativi destinati a fallire di fronte alla prudenza, alla competenza e ai multilivelli di controllo che caratterizzano la sfera del comando nucleare.

Madeleine Maresca, 21 gennaio 2026