Il riconoscimento facciale viola la privacy

FAVOREVOLE O CONTRARIO?

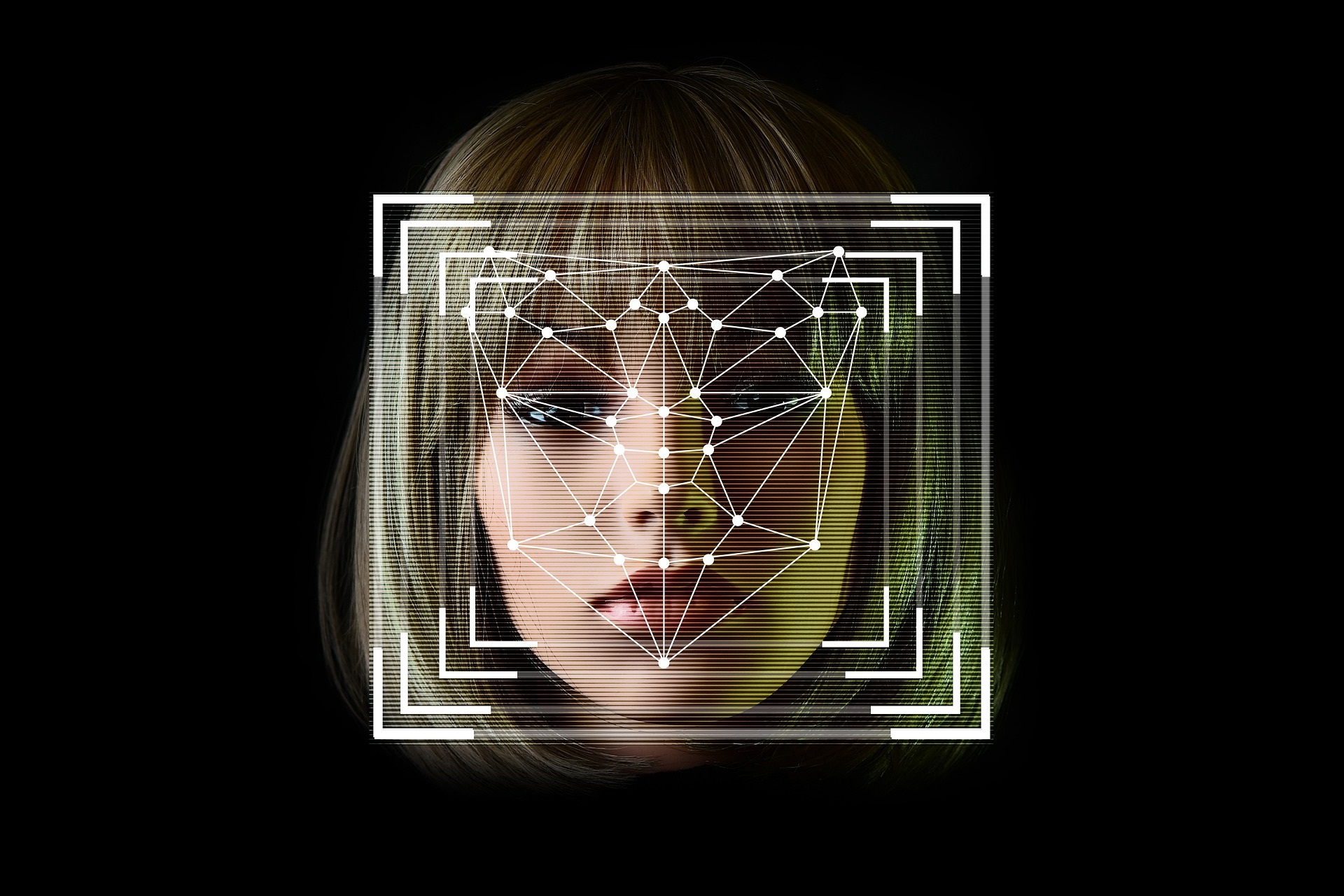

Negli ultimi anni, la tecnologia di riconoscimento facciale è passata dalle pagine dei romanzi di fantascienza ai sistemi di sicurezza degli aeroporti. Ma mentre l’opinione pubblica si abitua lentamente a sbloccare lo schermo con uno sguardo, un numero crescente di esperti, giuristi e attivisti si interroga su un punto essenziale: che cosa accade alla nostra privacy, quando il nostro volto diventa un dato?

IL DIBATTITO IN 2 MINUTI:

Anche se non hai commesso né dato il tuo consenso, diventi un dato, un codice biometrico, una sequenza in un sistema di sorveglianza invisibile.

Questa tecnologia può convivere con i diritti fondamentali, se integrata con norme robuste, criteri etici e una gestione trasparente.

Con le tecnologie biometriche, stiamo assistendo a un progressivo svuotamento del diritto alla privacy.

Il riconoscimento facciale è una tecnologia che accelera i processi investigativi, aumenta l’efficacia delle azioni di giustizia, migliora la sicurezza di milioni di persone.

Il volto è permanente, una volta che viene acquisito da un sistema di sorveglianza non esiste più alcun modo realistico per riprenderselo.

Il riconoscimento facciale è utilizzato per ritrovare minori scomparsi, persone con demenza o vittime di tratta. Può essere uno strumento salvavita.

Il riconoscimento facciale è una minaccia alla privacy: una tecnologia troppo pericolosa per essere normalizzata

Immagina di camminare per strada, di partecipare a una manifestazione, o semplicemente di entrare in un negozio. Senza che tu lo sappia, il tuo volto viene scansionato, confrontato con milioni di immagini, archiviato in un database che non hai mai autorizzato. Non hai commesso nessun crimine, non hai dato il tuo consenso, eppure sei diventato un dato, un codice biometrico, una sequenza in un sistema di sorveglianza invisibile. Questo non è un romanzo distopico: è la realtà documentata dell’uso del riconoscimento facciale nel mondo contemporaneo.

Le prove raccolte dalle 17 fonti analizzate parlano chiaro. Il riconoscimento facciale è intrusivo, inaffidabile e discriminatorio, ed è già stato utilizzato per commettere abusi gravi. Il caso emblematico di LaDonna Crutchfield, arrestata ingiustamente a Detroit a causa di un errore di identificazione, mostra quanto possa essere devastante l’uso sconsiderato di questa tecnologia (Reason.com, 2025). E non si tratta di un caso isolato: la città di Detroit è stata oggetto di tre cause legali per arresti ingiustificati basati su FRT (JURIST, 2025).

Questa tecnologia non solo amplifica le disuguaglianze, ma opera spesso in assenza di trasparenza e controllo pubblico. Come denunciano l’ACLU del Wisconsin e il Center for Democracy & Technology, molte forze dell’ordine americane utilizzano il riconoscimento facciale senza alcun coinvolgimento democratico, senza valutazioni d’impatto e senza strumenti di verifica indipendenti. Le comunità più colpite? Sempre le stesse: afroamericani, minoranze etniche, persone LGBTQ+, manifestanti politici.

Il caso Clearview AI è emblematico. Secondo “Reuters” (2025), l’azienda ha costruito un database con oltre 30 miliardi di immagini raccolte illegalmente, e ha patteggiato in tribunale offrendo quote societarie in cambio della chiusura della class action. È un precedente pericoloso: i cittadini sono diventati merce di scambio, e i loro volti una valuta da trattare nei mercati della sorveglianza.

Anche nei contesti legislativi più avanzati, le tutele non sono sufficienti. Il rapporto di EPIC (2025) rivela che a San Francisco, dove l’uso del FRT è formalmente vietato, la polizia ha aggirato il divieto collaborando con contee limitrofe. Il divieto formale non è garanzia di rispetto sostanziale, e ciò che non è visibile può essere più pericoloso.

Come sottolineato dallo studio accademico di Montasari (“Springer”, 2024), il problema è strutturale. La tecnologia di riconoscimento facciale nasce per classificare, confrontare, individuare, e non può essere addomesticata senza perdere la sua funzione principale. Ogni implementazione “etica” rischia di essere una foglia di fico, dietro cui si cela una logica di sorveglianza diffusa e normalizzata.

Non è sufficiente regolamentare, perché ciò che viene normalizzato oggi sarà irriformabile domani. I sistemi biometrici sono per loro natura persistenti, difficili da cancellare, soggetti a furti (come il caso Biostar2) e alla monetizzazione incontrollata. Come dichiarato nel rapporto “Identity.com”, “non esiste modo di cambiare volto come si cambia una password”.

Il riconoscimento facciale non è solo una questione tecnica o giuridica, ma una sfida politica ed esistenziale. È una tecnologia che ristruttura il potere: chi guarda e chi è guardato, chi controlla e chi è controllato. In un mondo che valorizza la dignità, la libertà e l’autonomia dell’individuo, questa tecnologia non può e non deve essere accettata. Per difendere la privacy, bisogna dire no. E dirlo ora, prima che sia troppo tardi.

Nina Celli, 19 aprile 2025

Il riconoscimento facciale non è una minaccia alla privacy, se inserito in un quadro etico e normativo trasparente

Nell’immaginario collettivo, la tecnologia di riconoscimento facciale evoca spesso scenari distopici: occhi elettronici che scrutano ogni volto, archivi digitali che raccolgono identità senza consenso, algoritmi che decidono chi è sospetto e chi no. Ma se ci liberiamo per un attimo dalle rappresentazioni apocalittiche e guardiamo alla realtà delle cose, scopriamo che questa tecnologia può convivere con i diritti fondamentali, se integrata con norme robuste, criteri etici e una gestione trasparente.

In numerosi casi, il riconoscimento facciale ha già dimostrato il suo potenziale per rafforzare la sicurezza pubblica, prevenire crimini, identificare soggetti pericolosi o aiutare nella localizzazione di persone scomparse. Come evidenziato dallo studio di Montasari (“Springer”, 2024), l’equilibrio tra utilità e intrusività è possibile: la chiave è costruire un’architettura regolativa che riconosca la natura sensibile dei dati biometrici, ma non demonizzi il progresso.

Uno dei principali equivoci che circondano la tecnologia FRT (Facial Recognition Technology) è che essa sia “di per sé” una violazione della privacy. Ma la violazione non è insita nello strumento, bensì nel suo uso senza regole. Secondo l’analisi pubblicata dal Center for Democracy & Technology (CDT, 2025), molte agenzie federali statunitensi già impiegano sistemi di riconoscimento facciale, e il vero problema non è la tecnologia in sé, ma la mancanza di standard comuni per l’uso, la trasparenza e la valutazione dei rischi.

Il Connecticut, ad esempio, sta dimostrando che una normativa efficace è possibile. Il suo Data Privacy Act (2025) vieta l’uso di FRT senza informativa e consenso, impone la cancellazione dei dati e vieta il targeting minorile. Questo dimostra che tecnologia e privacy non sono nemiche, ma interlocutrici: serve solo un legislatore consapevole, un’autorità indipendente e una cittadinanza informata.

Alcune voci critiche sostengono che il riconoscimento facciale rafforzi la sorveglianza di massa. È vero, esistono abusi documentati (come il caso Crutchfield a Detroit), ma ciò non significa che ogni applicazione sia illegittima. Anche la tecnologia più neutrale può essere distorta, se non controllata. Come suggerisce l’articolo accademico pubblicato su “Frontiers in Big Data” (2024), la sfida non è fermare l’innovazione, ma disciplinarla, imponendo accuratezza, minimizzazione dei dati, trasparenza e coinvolgimento pubblico.

La regolazione non è una mera questione giuridica. È un atto culturale e politico, come afferma Joshua Villanueva su “JURIST”: significa rifiutare una visione paternalista del potere tecnologico e optare per un modello in cui la persona rimane al centro. “Tecnologia con supervisione” non è uno slogan, ma una strategia: algoritmi auditabili, accesso ai log, divieto di profilazione automatica, revisione umana obbligatoria. Tutti strumenti per assicurare che la tecnologia serva le persone, e non il contrario.

Non è il riconoscimento facciale, quindi, a violare la privacy, ma l’assenza di una cornice giuridica che lo disciplini. Se regolato in modo democratico, con standard condivisi, controllo pubblico e finalità proporzionate, può diventare uno strumento al servizio della sicurezza, del diritto e persino della dignità umana.

Nina Celli, 19 aprile 2025

Il riconoscimento facciale mina le fondamenta della democrazia: il volto come dato, la persona come sorvegliato

In ogni società libera, la privacy non è un lusso, ma un diritto fondante. È la condizione che permette agli individui di pensare, esprimersi, dissentire e vivere senza la paura costante di essere osservati. Ma oggi, con l’espansione globale delle tecnologie biometriche, stiamo assistendo a un progressivo svuotamento di questo diritto, spesso senza accorgercene. Il riconoscimento facciale, in particolare, sta trasformando ogni spazio pubblico in una potenziale scena del crimine, ogni volto in una prova da verificare.

Il problema, come emerso in maniera cristallina dall’analisi del report di “Brookings” (2025), non è solo tecnico. È strutturale, sistemico. L’impiego del riconoscimento facciale da parte delle autorità, anche democratiche, ha portato a forme sottili ma pervasive di sorveglianza preventiva, come il monitoraggio dei social media da parte del Dipartimento della Sicurezza Interna negli Stati Uniti. Si tratta di un’anticipazione orwelliana della colpa: non si aspetta più che un crimine venga commesso, ma si cerca di identificarlo nel comportamento potenziale, nelle associazioni, nei volti. In un contesto del genere, la libertà di espressione, di movimento e di protesta non è più garantita. La stessa ACLU del Wisconsin (2025) ha denunciato l’uso di droni e FRT da parte della polizia per monitorare manifestazioni e sorvegliare attivisti LGBTQ+. Il pericolo non è solo teorico: è documentato. È reale. Il volto umano, che un tempo era l’emblema dell’identità, viene oggi trasformato in un token algoritmico, leggibile, archiviabile, confrontabile.

Le implicazioni democratiche sono gravi. Come spiegato nell’analisi accademica pubblicata su “Springer” (Montasari, 2024), il riconoscimento facciale capovolge l’onere della prova: non è più l’accusa a dover dimostrare la colpa, ma il cittadino a dover dimostrare la sua innocenza davanti a un sistema di sorveglianza invisibile. La presunzione di innocenza viene scardinata da una logica algoritmica di probabilità, dove la verità viene delegata al codice.

Anche quando esistono normative, come nel caso del Connecticut Data Privacy Act, esse risultano spesso insufficienti, inapplicate o aggirate. Il report EPIC (2025) rivela che, pur in presenza di divieti, forze dell’ordine locali hanno utilizzato banche dati biometriche di altre contee per identificare persone. Questo dimostra che la sorveglianza biometrica non conosce confini, né normativi né etici, quando si inserisce in un sistema che la legittima come “normale”.

La normalizzazione è infatti il rischio più subdolo. Quando ci abituiamo a telecamere intelligenti in metropolitana, scanner biometrici nei negozi e sistemi di identificazione automatica nei tribunali, il volto perde il suo valore simbolico di identità e diventa solo una chiave d’accesso a un database di controllo. Non è solo un rischio per la privacy individuale, ma per l’idea stessa di cittadinanza: quella che ci vuole uguali, non profilati; liberi, non schedati.

Come affermato nel saggio Facial Recognition in Governance (2024), esiste una soglia oltre la quale l'efficienza tecnologica diventa tirannia algoritmica. Superata quella soglia, non sarà più possibile tornare indietro. Per questo, la sola regolamentazione non basta. Bisogna porre limiti chiari, netti, radicali, fino a vietarne l’uso in ambito pubblico, se necessario.

Il riconoscimento facciale non è una semplice tecnologia: è una lente attraverso cui lo Stato osserva il cittadino, ma anche un meccanismo con cui lo definisce, lo classifica e lo controlla. In una democrazia degna di questo nome, nessuna persona dovrebbe temere di essere guardata solo per il fatto di esistere. Ecco perché, per difendere le basi stesse della libertà, questa tecnologia deve essere fermata.

Nina Celli, 19 aprile 2025

La tecnologia può tutelare i diritti fondamentali, se vincolata da trasparenza e giustizia algoritmica

Il riconoscimento facciale rappresenta una risorsa che, se ben regolata, può servire all’interesse pubblico. La questione centrale non è se utilizzare questa tecnologia, ma come, quando e con quali garanzie. Il riconoscimento facciale, come illustrato nel report del Center for Democracy & Technology (2025), viene già impiegato da decine di agenzie federali negli Stati Uniti. Viene utilizzato per l’identificazione nei valichi di frontiera, nella lotta al traffico di esseri umani e nell'individuazione di soggetti pericolosi. In questi ambiti, la tecnologia non solo accelera i processi investigativi, ma aumenta l’efficacia delle azioni di giustizia, migliorando la sicurezza di milioni di persone. Non impiegarla significherebbe rinunciare a un vantaggio concreto nella difesa dei diritti collettivi.

Ma l’efficacia non basta: serve equità. Le critiche alla tecnologia non vanno ignorate, ma integrate in una strategia di miglioramento. Come mostra lo studio AI-Powered Facial Recognition in Governance (“Technology in Society”, 2024), i bias algoritmici sono riducibili tramite dataset bilanciati, auditing indipendenti e obblighi di trasparenza. La regolazione non è un'illusione: è già realtà in giurisdizioni come l’UE, dove l’AI Act vieta gli usi più pervasivi, ma consente impieghi giustificati, previa valutazione d’impatto.

Lo stesso principio è applicato nel Connecticut Data Privacy Act (2025), dove il legislatore ha imposto limiti stringenti all’uso del riconoscimento facciale da parte di aziende e pubbliche amministrazioni, introducendo meccanismi per la revoca del consenso, il diritto alla cancellazione, e l’obbligo di notificare qualsiasi violazione dei dati biometrici. Questi esempi dimostrano che l’interesse pubblico e la protezione della privacy non sono antitetici, ma complementari.

Il vantaggio più spesso trascurato è quello della responsabilizzazione istituzionale. Se un sistema di FRT è certificato, auditato e monitorato da organismi indipendenti, può costituire uno strumento di contrasto agli abusi, persino all’interno delle forze dell’ordine. In paesi dove la corruzione o l’inefficienza ostacolano la giustizia, la tecnologia può fungere da garante oggettivo della verità, riducendo discriminazioni basate su pregiudizi umani.

Anche la società civile può trarre vantaggio. Come proposto da Joshua Villanueva su “JURIST”, un framework etico per il FRT può includere principi di minimizzazione, temporaneità, accountability e controllo pubblico. L’obiettivo non è quello di permettere una sorveglianza diffusa, ma di usare la tecnologia come strumento di trasparenza verso lo Stato, obbligandolo a dichiarare quando e perché la tecnologia viene utilizzata.

Va considerato, inoltre, un paradosso sottile: oggi la privacy viene violata molto più spesso da privati che da governi. App, social network, operatori pubblicitari: raccolgono dati biometrici ogni giorno, senza consenso esplicito, e spesso li rivendono. Il riconoscimento facciale, se regolato, può diventare un’occasione per educare il cittadino al controllo dei propri dati, invertendo il paradigma di passività.

Vietare quindi il riconoscimento facciale equivale a rinunciare alla possibilità di renderlo giusto. La vera sfida non è fermare l’innovazione, ma imbrigliarla in una logica di diritto, equità e partecipazione pubblica. Solo così la tecnologia diventa uno strumento al servizio della democrazia.

Nina Celli, 19 aprile 2025

Una volta acquisito, il volto non può più essere protetto: il riconoscimento facciale è un punto di non ritorno

C’è qualcosa di irrimediabile nel riconoscimento facciale. A differenza di una password, che si può cambiare, o di una carta d’identità, che si può sostituire, il volto è permanente, insostituibile, inalterabile. È l’unico documento che ci accompagna dalla nascita alla morte. E una volta che viene acquisito da un sistema di sorveglianza – pubblico o privato – non esiste più alcun modo realistico per riprenderselo.

Le implicazioni di questa caratteristica sono enormi. Come sottolineato nel report di “Identity.com” (2025), i furti di dati biometrici non sono un’eventualità, ma una realtà già documentata: 27,8 milioni di record rubati da Biostar2, il database di sicurezza fisica utilizzato in aziende, scuole e ospedali. E se oggi questi dati vengono usati per accedere a edifici o conti bancari, domani potrebbero essere impiegati per profilare cittadini, manipolare voti, o criminalizzare identità.

Questa vulnerabilità strutturale è ciò che distingue il riconoscimento facciale da qualsiasi altra forma di tecnologia digitale. Non stiamo parlando solo di sorveglianza, ma di una forma di schedatura permanente, basata su dati biologici. Secondo lo studio accademico Beyond Surveillance (“Frontiers in Big Data”, 2024), l’esistenza stessa di database biometrici modifica la relazione tra cittadini e Stato: non sei più un soggetto di diritto, ma un oggetto analizzabile. Ogni spostamento, ogni interazione, ogni espressione facciale può essere convertita in metadato.

Le conseguenze sono già visibili. Come mostra il report di EPIC (2025), a San Francisco – città che aveva formalmente vietato l’uso della FRT – la polizia ha continuato a utilizzarla attraverso collaborazioni con contee adiacenti. Questo dimostra che anche quando esiste una legge, la tecnologia crea le condizioni per essere aggirata, sfruttando zone grigie e assenza di accountability. L’illusione del controllo normativo crolla di fronte alla pervasività e portabilità del software.

C’è poi un problema di asimmetria informativa. I cittadini non sanno quando vengono scansionati, chi gestisce i loro dati, dove vengono archiviati, e per quanto tempo. Questa opacità erode la fiducia democratica, come ha messo in luce il Center for Democracy & Technology analizzando le AI Inventories delle agenzie federali: molte di esse non indicano nemmeno i fornitori dei software utilizzati, né pubblicano valutazioni d’impatto. Il risultato è una democrazia opaca, dove la trasparenza è un privilegio e non un diritto.

Persino le promesse di giustizia algoritmica sono, a oggi, insoddisfacenti. Lo dimostrano i dati raccolti da “Brookings” e “CDT”: i sistemi continuano a sbagliare con maggiore frequenza nel riconoscere donne, persone nere e minoranze etniche. Eppure, vengono implementati lo stesso, perché l’efficienza tecnica viene anteposta all’equità sociale. Ma il vero problema è ancora più profondo. Come affermato nel libro di Reza Montasari (“Springer”, 2024), la tecnologia cambia il significato stesso della privacy. Una volta che accettiamo che i nostri volti possano essere letti, analizzati e confrontati in tempo reale, la soglia culturale dell’accettabilità si abbassa. Si normalizza la sorveglianza. Si assorbe l’idea che la sicurezza giustifichi ogni cosa.

Il riconoscimento facciale non è semplicemente una tecnologia da regolare. È una frontiera che, una volta oltrepassata, non permette ritorni. Per questo non bastano controlli, limiti o audit: serve un principio netto. Serve affermare che il volto umano non può essere trattato come una password pubblica. In una società democratica, la protezione della nostra identità più profonda – il nostro volto – deve rimanere inviolabile.

Nina Celli, 19 aprile 2025

Il riconoscimento facciale, se progettato con giustizia, può rafforzare l’inclusione e proteggere i vulnerabili

Nella narrazione dominante, il riconoscimento facciale è spesso dipinto come uno strumento al servizio del potere, una macchina opaca che sorveglia i cittadini. Eppure, esiste un’altra storia, meno raccontata ma altrettanto reale: quella di una tecnologia che, se sviluppata con giustizia algoritmica e trasparenza, può diventare un’alleata dei diritti, della sicurezza e dell’inclusione.

L’esempio più tangibile arriva dall’ambito della protezione delle persone vulnerabili. Secondo lo studio AI-Powered Facial Recognition in Governance (2024), il riconoscimento facciale è già utilizzato in molti contesti per ritrovare minori scomparsi, persone con demenza o vittime di tratta. In questi casi, la tecnologia non è uno strumento di oppressione, ma un salvavita. Immagina un anziano con Alzheimer che si perde in città e viene riconosciuto da un sistema che lo riporta a casa. O una vittima di sfruttamento sessuale identificata in un video tramite FRT e finalmente sottratta ai suoi aguzzini.

Questo tipo di utilizzo richiede tuttavia un’architettura etica rigorosa, che non si limiti alla “buona fede” ma garantisca il rispetto sistemico dei diritti. Ed è qui che entrano in gioco le raccomandazioni elaborate da Villanueva (“JURIST”, 2025): temporaneità nell’uso dei dati, minimizzazione delle informazioni raccolte, audit pubblici, supervisione civile e possibilità per l’utente di accedere, correggere e cancellare i propri dati biometrici. Questo approccio trasforma la tecnologia in una infrastruttura di responsabilità, dove ogni azione è tracciabile e ogni abuso prevenibile.

Una delle obiezioni più comuni riguarda i bias algoritmici. Ed è giusto. Le analisi condotte dal Brookings Institute e Frontiers in Big Data documentano errori gravi nei riconoscimenti, specialmente su volti neri e femminili. Ma la soluzione non è vietare la tecnologia tout court, bensì investire nella sua giustizia interna. Dataset diversificati, test etici indipendenti, inclusione di minoranze nei team di sviluppo: sono tutte pratiche già in uso in alcuni progetti open source e in laboratori universitari. Come nella medicina, non si abbandona una cura perché è imperfetta, ma si lavora per migliorarla.

C’è anche un aspetto simbolico e culturale. Oggi milioni di persone usano il riconoscimento facciale ogni giorno per sbloccare i telefoni, accedere ai conti bancari o attraversare un aeroporto. Queste stesse persone meritano che la loro tecnologia sia soggetta a regole pubbliche, non solo a logiche di mercato. Regolarla significa democratizzarla, sottraendola al controllo esclusivo delle Big Tech e restituendola alla collettività.

In questo senso, il caso del Connecticut Data Privacy Act è illuminante. Qui, l’uso del FRT è permesso solo previo consenso, con forti limiti sulla condivisione dei dati, e obblighi di trasparenza. È un esempio concreto di modello normativo avanzato, che protegge i cittadini senza rinunciare alle potenzialità del progresso.

Vietare del tutto il riconoscimento facciale rischia di avere un effetto paradossale: spingere il suo utilizzo nel settore privato, fuori da ogni controllo. Già oggi molte aziende raccolgono dati biometrici tramite app, telecamere pubblicitarie e sistemi di fidelizzazione, spesso senza che l’utente ne sia consapevole. Un quadro regolativo serio consente invece di riportare questi processi alla luce del sole.

La tecnologia di riconoscimento facciale non è per forza un nemico della privacy. Può diventare un suo alleato, se progettata con etica, giustizia e partecipazione. La sfida non è cancellare questa innovazione, ma restituirla ai cittadini, garantendo che ogni volto resti prima di tutto ciò che è: umano, libero, rispettato.

Nina Celli, 19 aprile 2025